티스토리 뷰

[논문읽기][EfficientNet]Rethinking Model Scaling for Convolutional Neural Networks

무엇보다_빛나는_샤트 2022. 2. 16. 23:36안녕하세요

프로그래밍을 배우는 빛나는 샤트입니다.

Abstract, Introduction을 읽고 제 언어대로 해석해 적은 것입니다.

전체 내용은 추후 업데이트 예정입니다.

일시: 2021.05.11(화)

오늘 읽어볼 논문은 'Rethinking Model Scaling for Convolutional Neural Networks'입니다.

논문 링크: arxiv.org/pdf/1905.11946.pdf

Abstract(요약)

기존의 ConvNet들은 고정된 resource에 의해 개발되었다. 하지만 이러한 경우 성능(정확도) 개선에 한계를 느끼게 된다.

이 논문에서는 depth, width, resolution을 조절해 성능을 향상시킬 수 있다. 여기에서는 depth, width, resolution을 균일하게 비율을 키우는 방법인 compound coefficient을 이용해 최고로 효율적인 수치를 찾아냈다. 이 논문에서는 MobileNets, ResNet을 이용해 실험을 진행했다.

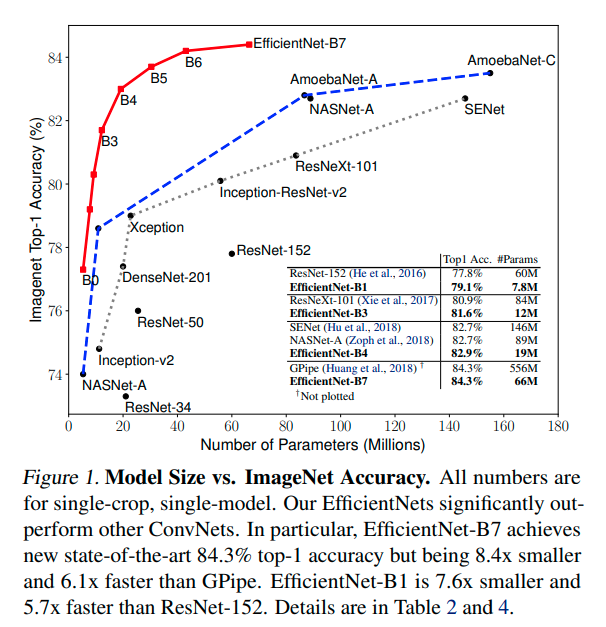

논문에서 개발한 EfficientNet-B7은 이미지 넷에서 top-1 accuracy 달성.

기존 SOTA대비해서 8.4배 작고 6.1배 빠르다고 한다.

또한 CIFAR-100에서는 기존 SOTA대비해서 정확도 부분에서 91.7%를 달성.

1. Introduction(소개)

ConvNet들의 Scaling Up 방법을 이용하면 정확도가 상승하는 것을 알 수 있다.

예를 들어 ResNet은 ResNet-18에서 ResNet-200으로 레이어를 쌓아서 Scale up할 수 있다.

최근에서는 GPipe가 이미지넷에서 정확도 84.3%를 달성했다. (기존 대비 4배 더 크다)

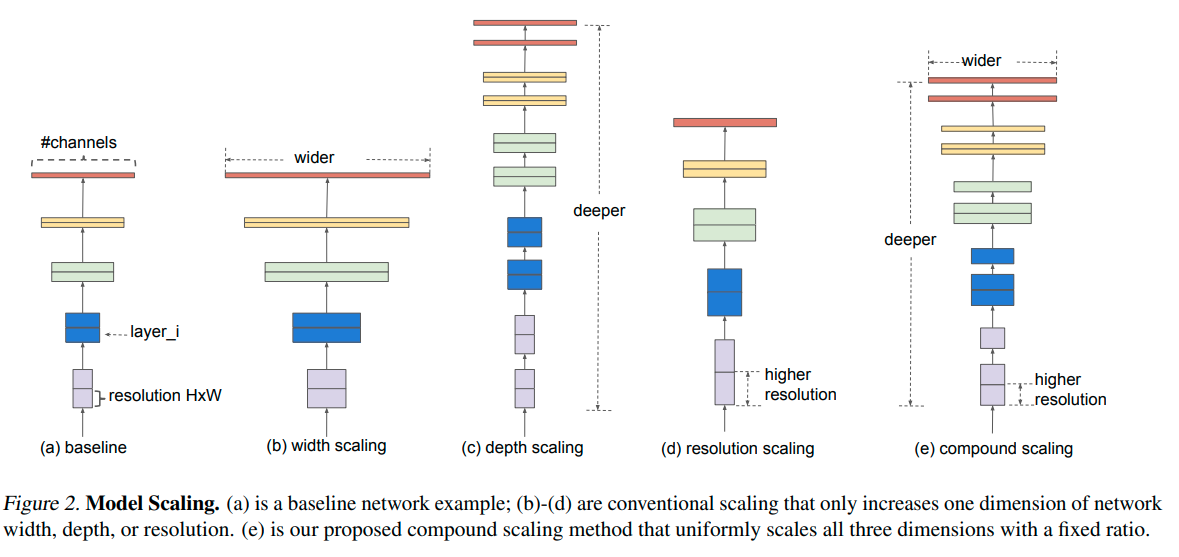

ConvNet들의 Scale Up의 가장 흔한 방법은 depth, width를 증가하는 것.

하지만 image resolution을 이용하는 방법도 있다.

아래 그림은 모델 scaling에 관한 그림이다.

이 논문에서는 Scaling Up에 대한 새로운 Process를 제안.

효과적인 compound scaling method를 이용하는 것.

아래 그래프와 같이 모델 사이즈가 작음에도 불구하고 높은 정확도와 낮은 파라미터 수를 가진 것을 알 수 있다.

이 논문에서는 EfficientNet-B4를 제작했고 ResNet-50과 비교하면 정확도 76.3% -> 83.0% 상승을 확인.

또한 이미지 넷에서 높은 성능을 확인.

EfficientNet의 중요한 Point!

1. 기존의 모델을 이용해 depth, width, resolution을 이용해 성능 향상

2. 더 적은 파라미터 수, 더 높은 정확도를 달성함

3. AutoML을 이용한 결과가 사람이 설계하는 것보다 좋을 수 있다...?

내용에 오류가 있으면 피드백 언제나 환영입니다.😊

'ML DL' 카테고리의 다른 글

| [논문읽기][STARK]Learning Spatio-Temporal Transformer for Visual Tracking (0) | 2022.02.16 |

|---|---|

| [논문읽기][SSD]Single Shot MultiBox Detector (0) | 2022.02.16 |

| [논문읽기][DenseNet]Densely Connected Convolutional Networks 논문 읽기 (0) | 2022.02.16 |

| [논문읽기][ResNet] Deep Residual Learning for Image Recognition (0) | 2022.02.16 |

| [ML/DL]Precision@k, Recall@k (0) | 2022.02.16 |

- Total

- Today

- Yesterday

- 인공지능 교육

- AIFFEL

- AIFFEL인공지능과정

- 광주인공지능사관학교

- 도전

- SLAM공부

- 대전 인공지능

- 서빙로봇

- 양정연SLAM

- 모두의 연구소

- AIFFEL교육

- 자율주행기술

- 인공지능교육

- 멋쟁이사자처럼

- 배달로봇

- 광주

- 아이펠

- SLAM강의

- 광주AI

- 인공지능

- AIFFEL후기

- ros

- Python

- 해커톤

- 자율주행로봇

- 실내자율주행

- Slam

- IT

- 멘탈관리

- 모두의연구소

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | |

| 7 | 8 | 9 | 10 | 11 | 12 | 13 |

| 14 | 15 | 16 | 17 | 18 | 19 | 20 |

| 21 | 22 | 23 | 24 | 25 | 26 | 27 |

| 28 | 29 | 30 | 31 |