티스토리 뷰

2021. 10. 8. 18:29

안녕하세요

프로그래밍을 배우는 빛나는 샤트입니다.

SLAM 강의 26강. Introduction to Kalman Filter

*이 포스팅은 목원대학교 양정연 교수님의 SLAM강의 유튜브 영상을 보고 제작되었음을 밝힙니다.

출처: 26강. Introduction to Kalman Filter

26강. Introduction to Kalman Filter

🎉강의요약

1. Kalman Filter을 구하는 과정: 측정-추정-예측-업데이트

2. Model을 이용해 예측, Observation을 이용해 업데이트

3. x는 평균 x^, 분산P를 가지는데(x~N(x^,P)) 우리의 목표는 분산P를 최소화하는 것이다.

4. 분산P를 최소화하면 추정한 값과 실제값은 비슷하며 이를 위해서는 반복을 많이 수행해야 한다.

<5 Kalman Filter>

<Expectation in Probability>

노이즈가 '확률적'으로 생긴다.

나타나는 패턴이 명확하지 않고 모델링이 어렵다.

>> 기존 지식에 확률을 얹어야 한다.

기대값: 전체 사건과 확률의 총합

확률 밀도 함수(PDF): 1보다 크게 나올 수 있다.

<Goal of Kalman Filter>

연속적인 형태(미분을 포함)을 이산화시켜야 한다.

X는 실제 관절의 각도인데 정확히 알 수 없다. 관측한 Y를 이용해서 알아낸다.

대전제: X를 모른다, 관측한 Y를 이용해 추정. 어느 범주 안에 있다.

>> 과연 '그 범주'는 무엇일까?

예시) 내 친구는 키가 173~175 되는 것 같다.

X는 원래 상태. 10근처에 있다. 라는 가정을 해본다.

추정이 높다면(분산값이 작아지면) 정확도가 높아진 상태.

>> X는 특정한 값 주변에 특정한 분산을 가지고 있다. 문제를 분포의 형태로 보기 시작.

1. X는 추정한 값 (X hat)

2. X^': 다음 단계의 추정값(모델링에 투입해 얻은 결과)

3. 에러e = 다음 스텝의 결과와 현재를 비교한 값. 에러의 제곱해서 기대값을 구하면 '분산'. 에러가 차원을 가진다면 공분산.

4. 에러를 최소화하는 Gain을 구한다.(K)

5. 예측된 값, 칼만 필터, 관측z을 이용해 추정된 값과 Covariance P를 업데이트

이를 반복!

반복하지 않으면 좋아지지 않는다.

>> 여러번 반복을 해서 분산을 작게 만들어야 한다.'

예시) 졸업.

Measurement Noise: 교수님이 좋아하는 것 같다. 싫어하는 것 같다.

Process Noise: 우리가 이정도면 졸업하겠다. 못하겠다.

<Kalman Filter>

총 4가지 프로세스로 이루어짐.

측정-추정-업데이트-K gain

xk: System Dynamics에 Process Noise추가

zk: Measurement Noise 추가

x^(k|k-1), P^(k|k-1): k-1에서 k를 보는 미래를 보는 관점으로 예측 단계

> 과거에서 미래를 보는 형태

Sk, Kk: 이를 토대로 Kalman Gain 구한다.

y^k: z(관측값)에서 Observation model을 토대로 구한다. 업데이트

현재 스텝에서 봤던 P,x를 업데이트

> 실제 동작을 하고 나서 관측을 할 때 k일때 k를 본다.

!!Model을 가지고 예측. Observation을 이용해 업데이트!!

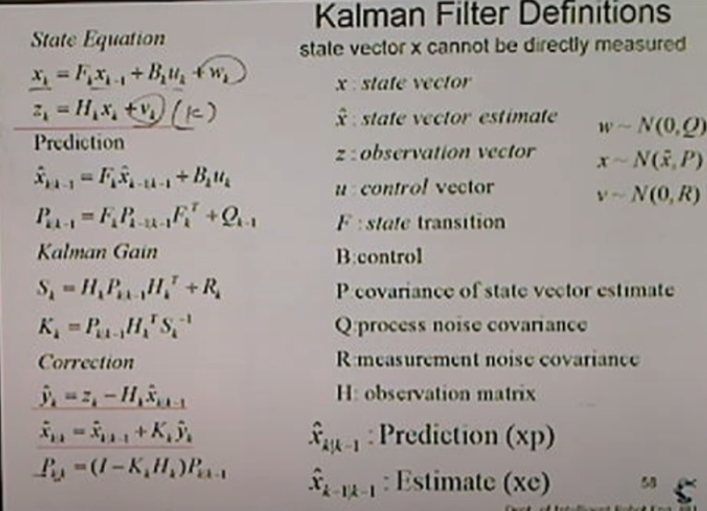

<Kalman Filter Definitions>

[State Equation]

xk내부에 x(k-1)이 있다. 이전 단계를 이용해 업데이트.

w~N(0,Q): 평균은 0, 분산은 Q

v~N(0,R): 평균은 0, 분산은 R

!!x~N(x^,P): 평균은 x_hat, 분산은 P!! -> 제일 중요

X^(k|k-1): 예측(xp)

X^(k-1|k-1): 추정(양쪽이 똑같다) (xe)

correction: 업데이트 과정.

관측한 것을 토대로 새로운 y생성

예측된 결과 + 칼만 게인 = 현재 보정값(x^(k|k))

예측했던 Covariance을 다시 추정하는 형태로 바꿔놓는다.

예측한 다음에 보정 하는 과정을 반복

<Derivation of K.F.>

예측(업데이트 전, 모델 기반 결과, 실제가 아님): A(k|k-1), A'

업데이트 후: A(k|k), A

우리의 목표: x^과 P를 구하면 분포를 구할 수 있다 x~N(x^,P), 분산값을 줄이는 것

Kalman Gain: P를 최소화하는 방법.

피드백은 언제나 환영합니다.😊

틀린 부분 있다면 지적해주시고 도움이 되었다면 댓글과 공감 눌러주세요

'SLAM' 카테고리의 다른 글

| [SLAM] 양정연 교수 SLAM 강의 28강. Kalman Gain in Kalman Filter (0) | 2022.02.21 |

|---|---|

| [SLAM] 양정연 교수 SLAM 강의 27강. Prediction in KF (0) | 2022.02.21 |

| [SLAM] 양정연 교수 SLAM 강의 25강. Why we need Observation? (0) | 2022.02.21 |

| [SLAM] 양정연 교수 SLAM 강의 24강. From math equation to State Equation (0) | 2022.02.21 |

| [SLAM] 양정연 교수 SLAM 강의 23강. Observation (0) | 2022.02.21 |

- Total

- Today

- Yesterday

- Slam

- SLAM공부

- 실내자율주행

- AIFFEL후기

- 대전 인공지능

- 인공지능교육

- 모두의 연구소

- IT

- 인공지능 교육

- 멋쟁이사자처럼

- 인공지능

- 해커톤

- 도전

- AIFFEL

- 배달로봇

- Python

- 자율주행기술

- 멘탈관리

- ros

- 광주AI

- 서빙로봇

- 자율주행로봇

- SLAM강의

- 광주인공지능사관학교

- 아이펠

- AIFFEL교육

- 광주

- 양정연SLAM

- AIFFEL인공지능과정

- 모두의연구소

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |