티스토리 뷰

2021. 10. 20. 03:36

안녕하세요

프로그래밍을 배우는 빛나는 샤트입니다.

SLAM 강의 32강. Markov System

*이 포스팅은 목원대학교 양정연 교수님의 SLAM강의 유튜브 영상을 보고 제작되었음을 밝힙니다.

출처: 32강. Markov System

32강. Markov System

🎉강의요약

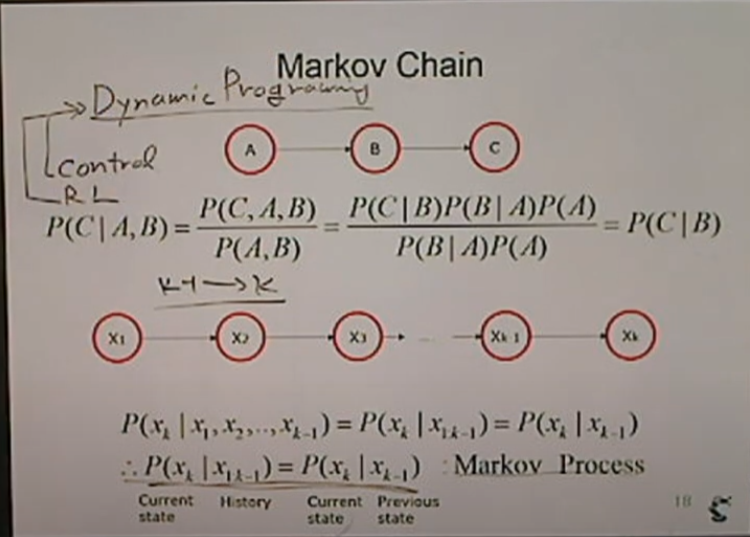

1. Markov System은 여러 state가 있을때 현재를 알고 싶다면 바로 이전 state만이 영향을 준다는 내용

2. x1부터 xk까지의 state가 있을때 xk를 알고 싶다면 xk-1을 알면 된다.

3. 또한 아래 첫 번째 그림처럼 A,B,C의 사건이 있을때 A는 C에 영향을 주지 못한다.

4. 많은 Dynamic Programming이 이러한 Markov Process에 기반을 두고 있다.

5. 조건부확률을 이용해 표현할 수 있다.

<Markov Chain>

사건A,B,C가 있다. A에서 B로 그리고 C로 넘어간다.

이 관계를 추적.

(중요)A는 C에 영향을 주지 않고 있다.

사건들이 독립적이다.

예시: 밥을 먹기위해 숟가락을 든다. 입에 넣는다. 소화가 된다.

숟가락을 드는 것과 소화가 되는 것은 연관이 없다.

P(C|A,B) = P(C|B)

이렇게 나타낼 수 가 있다!!

다시 생각해보면 A가 C에 영향을 주지 않으므로

P(C|A,B)에서 A를 제거하면 P(C|B)가 된다!

x1 ~ xk로 확장해서 생각해보자.

xk는 x1~xk-1한테서 모두 영향을 받는다.

하지만 Markov System으로 본다면 바로 이전 step만 생각한다.

즉, P(xk|x1,...,xk-1) = P(xk|xk-1) -> 이것이 Markov Process!

예시: 컨트롤. PID. 이전 상태(에러값)을 이용해 현재 상태를 보정.

Control, RL(강화학습) -> Dynamic Programming

> 이전 스텝을 이용해 다음 스텝을 보정하는 것을 의미. (에러를 좁히는 방향)

이러한 Dynamic Programming은 Markov System에 영향을 받은 것

미래를 위해서 현재를 가지고 조정. 현재는 과거를 가지고 조정.

예시: 블라인드 테스트. 이전 과거의 이력이 아닌 현재의 실력만을 가지고 면접을 진행한다.

현 단계가 좋지 않다 -> 이전 단계가 좋지 않았다. 라는 것도 의미

Markov의 의미: 현재를 알게 되면 과거를 모두 알 수 있다.

예시: 성적표를 확인해보면 과거의 모든 성적이 있다.

<Probability in Markov Process>

1. Markov Chain -> 과거의 어떤 일이 있는지 보지 않고 현 단계만 본다.

> Transitional Probability(절대 흔들리지 않는다. 고정)

예시: 작년에는 이정도 숙제 A, 올해는 B라면 Markov System이 아니다.

2. Joint Probability

정확하게는 Markov는 아니다.

사건 P(xk): 현재 = ∑(xk-1)P(xk, xk-1) = ∫P(xk|xk-1)P(xk-1)dxk-1

k-1스텝만 따진다. 처음부터 끝까지 단계 중 각 단계별로 처리하다보면 결국 끝의 단계인 P(x)를 알 수 있다.

피드백은 언제나 환영합니다.😊

틀린 부분 있다면 지적해주시고 도움이 되었다면 댓글과 공감 눌러주세요

'SLAM' 카테고리의 다른 글

- Total

- Today

- Yesterday

- SLAM공부

- 멘탈관리

- 양정연SLAM

- AIFFEL교육

- IT

- 광주인공지능사관학교

- 인공지능

- 광주

- 배달로봇

- 도전

- 광주AI

- 모두의 연구소

- 모두의연구소

- AIFFEL인공지능과정

- AIFFEL후기

- SLAM강의

- 인공지능 교육

- 인공지능교육

- 해커톤

- Slam

- AIFFEL

- 대전 인공지능

- 서빙로봇

- ros

- 아이펠

- Python

- 자율주행기술

- 자율주행로봇

- 멋쟁이사자처럼

- 실내자율주행

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |